python爬取链家二手房的数据

发布日期:2022-04-24 14:55 | 文章来源:gibhub

一、查找数据所在位置:

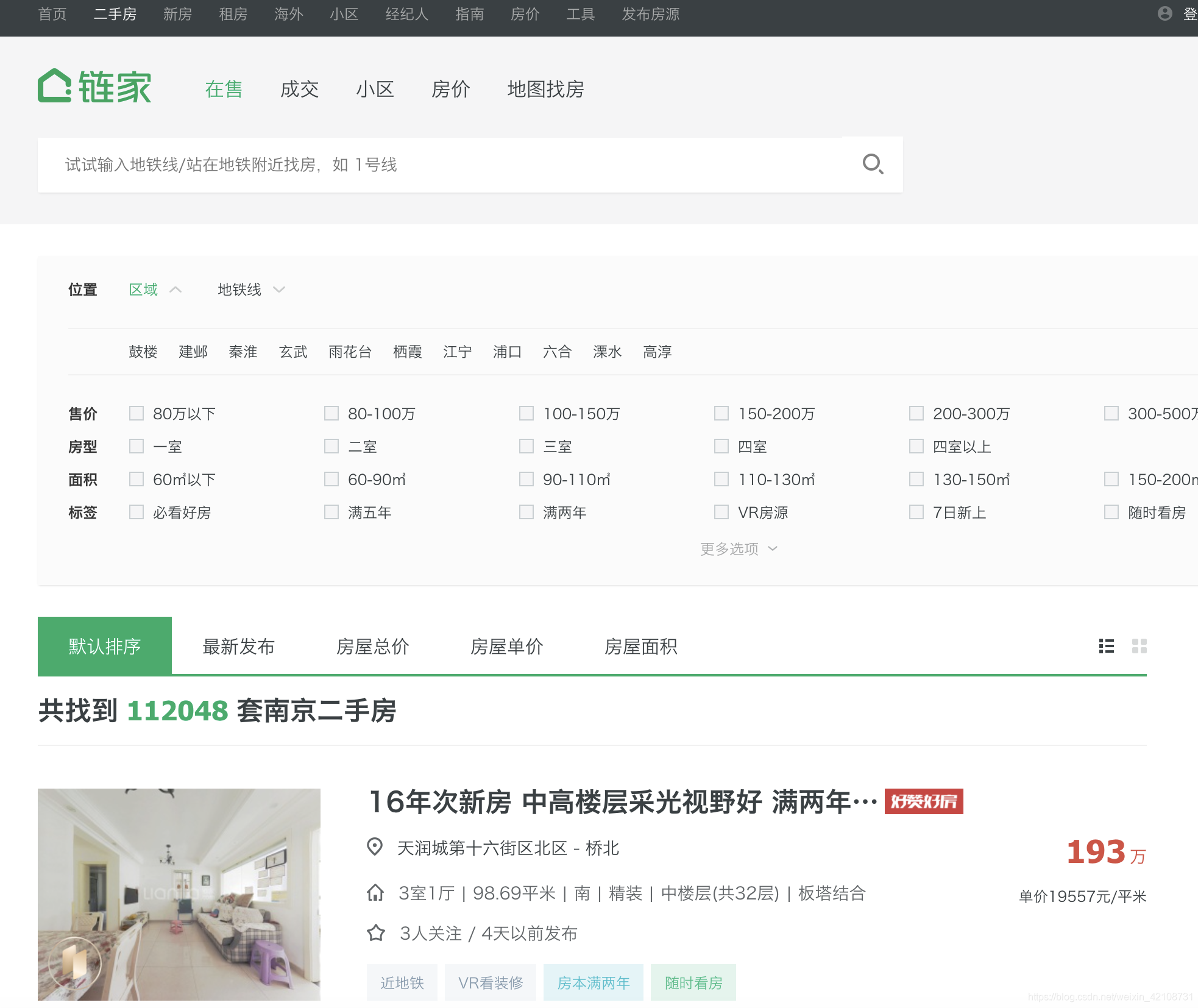

打开链家官网,进入二手房页面,选取某个城市,可以看到该城市房源总数以及房源列表数据。

二、确定数据存放位置:

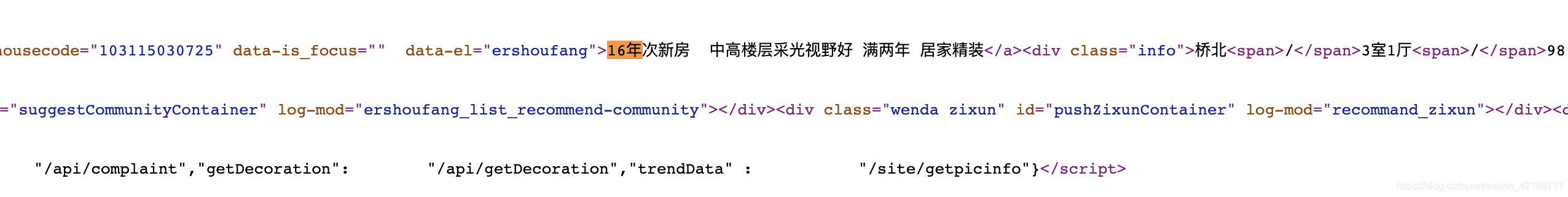

某些网站的数据是存放在html中,而有些却api接口,甚至有些加密在js中,还好链家的房源数据是存放到html中:

三、获取html数据:

通过requests请求页面,获取每页的html数据

# 爬取的url,默认爬取的南京的链家房产信息

url = 'https://nj.lianjia.com/ershoufang/pg{}/'.format(page)

# 请求url

resp = requests.get(url, headers=headers, timeout=10)

四、解析html,提取有用数据:

通过BeautifulSoup解析html,并提取相应有用的数据

soup = BeautifulSoup(resp.content, 'lxml')

# 筛选全部的li标签

sellListContent = soup.select('.sellListContent li.LOGCLICKDATA')

# 循环遍历

for sell in sellListContent:

# 标题

title = sell.select('div.title a')[0].string

# 先抓取全部的div信息,再针对每一条进行提取

houseInfo = list(sell.select('div.houseInfo')[0].stripped_strings)

# 楼盘名字

loupan = houseInfo[0]

# 对楼盘的信息进行分割

info = houseInfo[0].split('|')

# 房子类型

house_type = info[1].strip()

# 面积大小

area = info[2].strip()

# 房间朝向

toward = info[3].strip()

# 装修类型

renovation = info[4].strip()

# 房屋地址

positionInfo = ''.join(list(sell.select('div.positionInfo')[0].stripped_strings))

# 房屋总价

totalPrice = ''.join(list(sell.select('div.totalPrice')[0].stripped_strings))

# 房屋单价

unitPrice = list(sell.select('div.unitPrice')[0].stripped_strings)[0]

以上就是我的分享,如果有什么不足之处请指出,多交流,谢谢!

以上就是python爬取链家二手房的数据的详细内容,更多关于python爬取链家二手房的资料请关注本站其它相关文章!

版权声明:本站文章来源标注为YINGSOO的内容版权均为本站所有,欢迎引用、转载,请保持原文完整并注明来源及原文链接。禁止复制或仿造本网站,禁止在非www.yingsoo.com所属的服务器上建立镜像,否则将依法追究法律责任。本站部分内容来源于网友推荐、互联网收集整理而来,仅供学习参考,不代表本站立场,如有内容涉嫌侵权,请联系alex-e#qq.com处理。

相关文章

关注官方微信

关注官方微信