Pytorch实现网络部分层的固定不进行回传更新问题及思路详解

实际问题

Pytorch有的时候需要对一些层的参数进行固定,这些层不进行参数的梯度更新

问题解决思路

那么从理论上来说就有两种办法

- 优化器初始化的时候不包含这些不想被更新的参数,这样他们会进行梯度回传,但是不会被更新

- 将这些不会被更新的参数梯度归零,或者不计算它们的梯度

思路就是利用tensor的requires_grad,每一个tensor都有自己的requires_grad成员,值只能为True和False。我们对不需要参与训练的参数的requires_grad设置为False。

在optim参数模型参数中过滤掉requires_grad为False的参数。

还是以上面搭建的简单网络为例,我们固定第一个卷积层的参数,训练其他层的所有参数。

代码实现

class Net(nn.Module): def __init__(self): super(Net,self).__init__() self.conv1 = nn.Conv2d(3,32,3) self.conv2 = nn.Conv2d(32,24,3) self.prelu = nn.PReLU() for m in self.modules(): if isinstance(m,nn.Conv2d): nn.init.xavier_normal_(m.weight.data) nn.init.constant_(m.bias.data,0) if isinstance(m,nn.Linear): m.weight.data.normal_(0.01,0,1) m.bias.data.zero_() def forward(self, input): out = self.conv1(input) out = self.conv2(out) out = self.prelu(out) return out

遍历第一层的参数,然后为其设置requires_grad

model = Net()

for name, p in model.named_parameters():

if name.startswith('conv1'):

p.requires_grad = False

optimizer = torch.optim.Adam(filter(lambda x: x.requires_grad is not False ,model.parameters()),lr= 0.2)

为了验证一下我们的设置是否正确,我们分别看看model中的参数的requires_grad和optim中的params_group()。

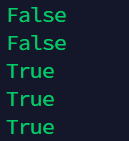

for p in model.parameters(): print(p.requires_grad)

能看出优化器仅仅对requires_grad为True的参数进行迭代优化。

LAST 参考文献

Pytorch中,动态调整学习率、不同层设置不同学习率和固定某些层训练的方法_我的博客有点东西-CSDN博客

到此这篇关于Pytorch实现网络部分层的固定不进行回传更新的文章就介绍到这了,更多相关Pytorch网络部分层内容请搜索本站以前的文章或继续浏览下面的相关文章希望大家以后多多支持本站!

版权声明:本站文章来源标注为YINGSOO的内容版权均为本站所有,欢迎引用、转载,请保持原文完整并注明来源及原文链接。禁止复制或仿造本网站,禁止在非www.yingsoo.com所属的服务器上建立镜像,否则将依法追究法律责任。本站部分内容来源于网友推荐、互联网收集整理而来,仅供学习参考,不代表本站立场,如有内容涉嫌侵权,请联系alex-e#qq.com处理。

关注官方微信

关注官方微信